Компания NVIDIA представила сегодня самый мощный в мире ускоритель вычислений — H200. Он построен на уже знакомой архитектуре NVIDIA Hopper, и фактически представляет собой обновлённую с помощью более скоростной памяти HBM3e версию популярного флагманского ускорителя H100. Новая память позволит ускорителю быстрее работать с огромными объемами данных для генеративного ИИ и высокопроизводительных вычислительных нагрузок.

Источник изображений: NVIDIA

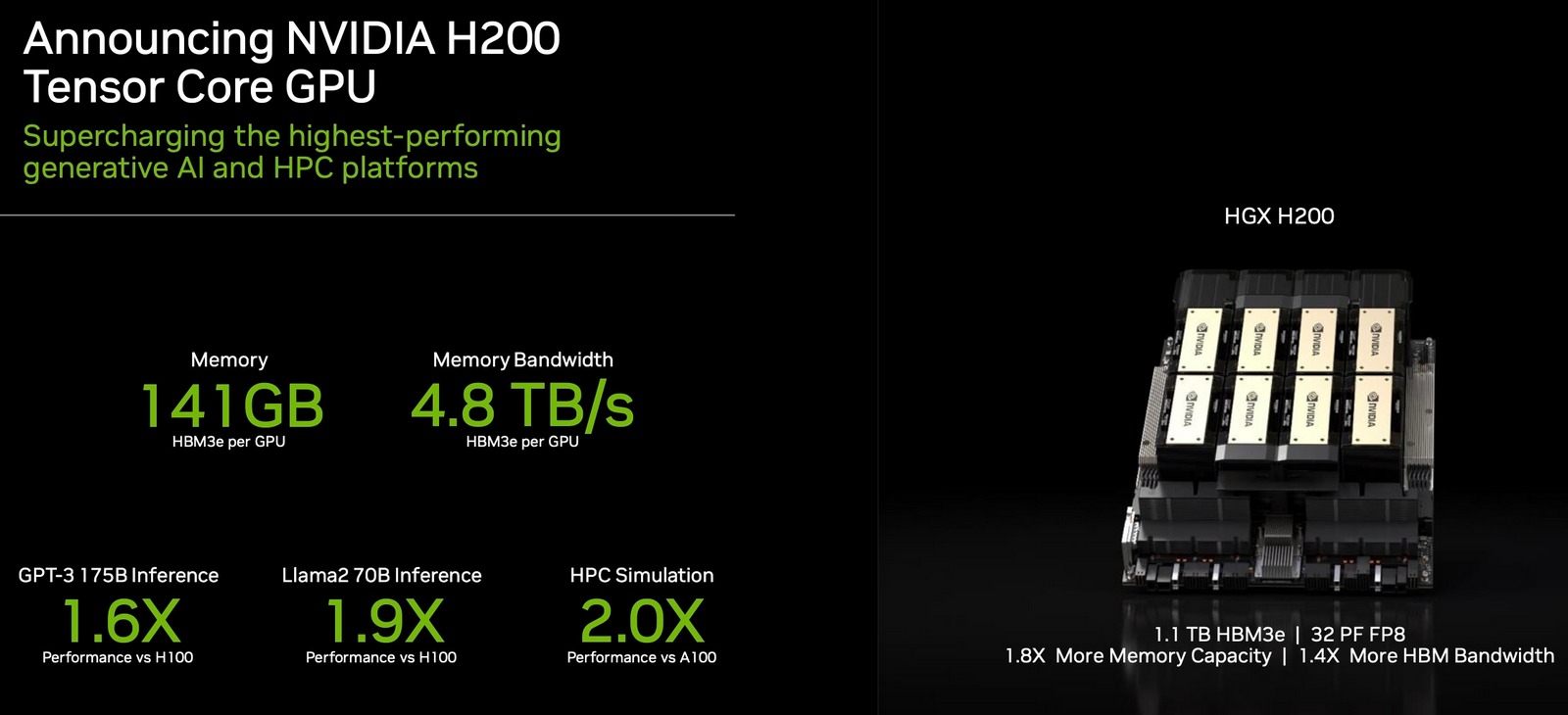

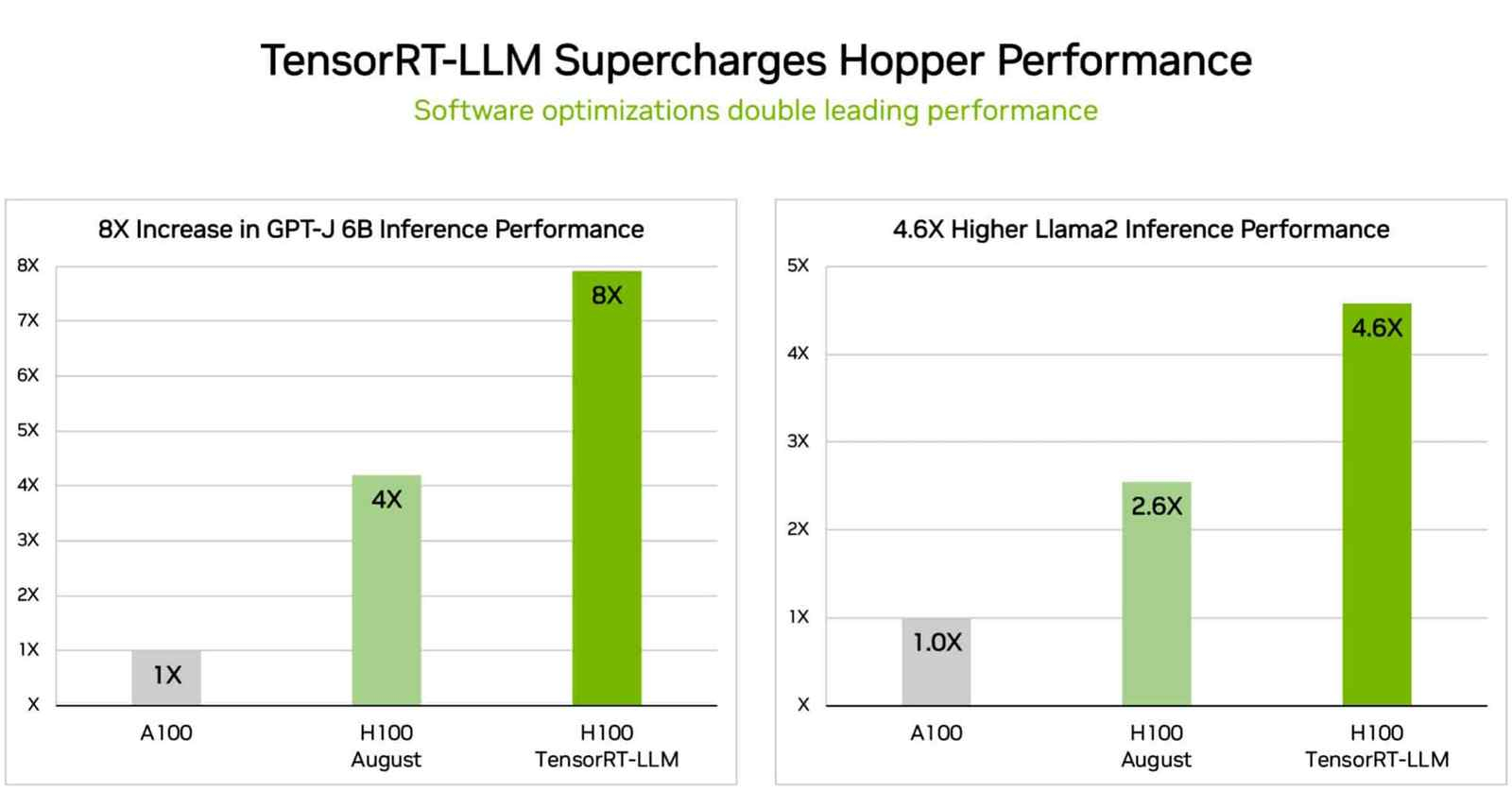

NVIDIA H200 — это первый графический процессор с памятью HBM3e, которая отличается от обычной HBM3 более высокой скоростью. NVIDIA H200 получил 141 Гбайт памяти HBM3e со скоростью 4,8 Тбайт/с, что почти вдвое больше по объему и в 2,4 раза больше по пропускной способности по сравнению с памятью ускорителя прошлого поколения NVIDIA A100. Для сравнения, у H100 имеется 80 Гбайт HBM3 со скоростью 3,35 Тбайт/с, тогда как грядущий ускоритель AMD Instinct MI300X получит 192 Гбайт памяти HBM3 со скоростью 5,2 Тбайт/с.

За счёт апгрейда памяти H200 обеспечит значительный рост производительности в работе уже обученных систем искусственного интеллекта (инференсе). Например, NVIDIA обещает увеличение скорости работы большой языковой модели Llama 2 с 70 млрд параметров в 1,9 раза, по сравнению с H100. А работу обученной модели GPT-3 с 175 млрд параметров новинка ускорит в 1,6 раза.

NVIDIA H200 будет доступна в серверных платах NVIDIA HGX H200 в конфигурациях с четырьмя и восемью ускорителями. Причём новинки совместимы как с аппаратным, так и с программным обеспечением систем HGX H100. Производители серверов, включая ASRock Rack, ASUS, Dell Technologies, Eviden, GIGABYTE, Hewlett Packard Enterprise, Ingrasys, Lenovo, QCT, Supermicro, Wistron и Wiwynn выпустят свои системы с ускорителями H200. В свою очередь Amazon Web Services, Google Cloud, Microsoft Azure и Oracle Cloud Infrastructure станут одними из первых поставщиков облачных услуг, которые со следующего года начнут предлагать инстансы на базе H200.

NVIDIA отмечает, что система HGX H200 с восемью ускорителями обеспечивает производительность более 32 Пфлопс (32 квадриллиона операций в секунду) в вычислениях FP8 для глубокого обучения. Причём такая система обеспечит в сумме 1,1 Тбайт памяти с высокой пропускной способностью для высочайшей производительности в генеративных приложениях ИИ и HPC.

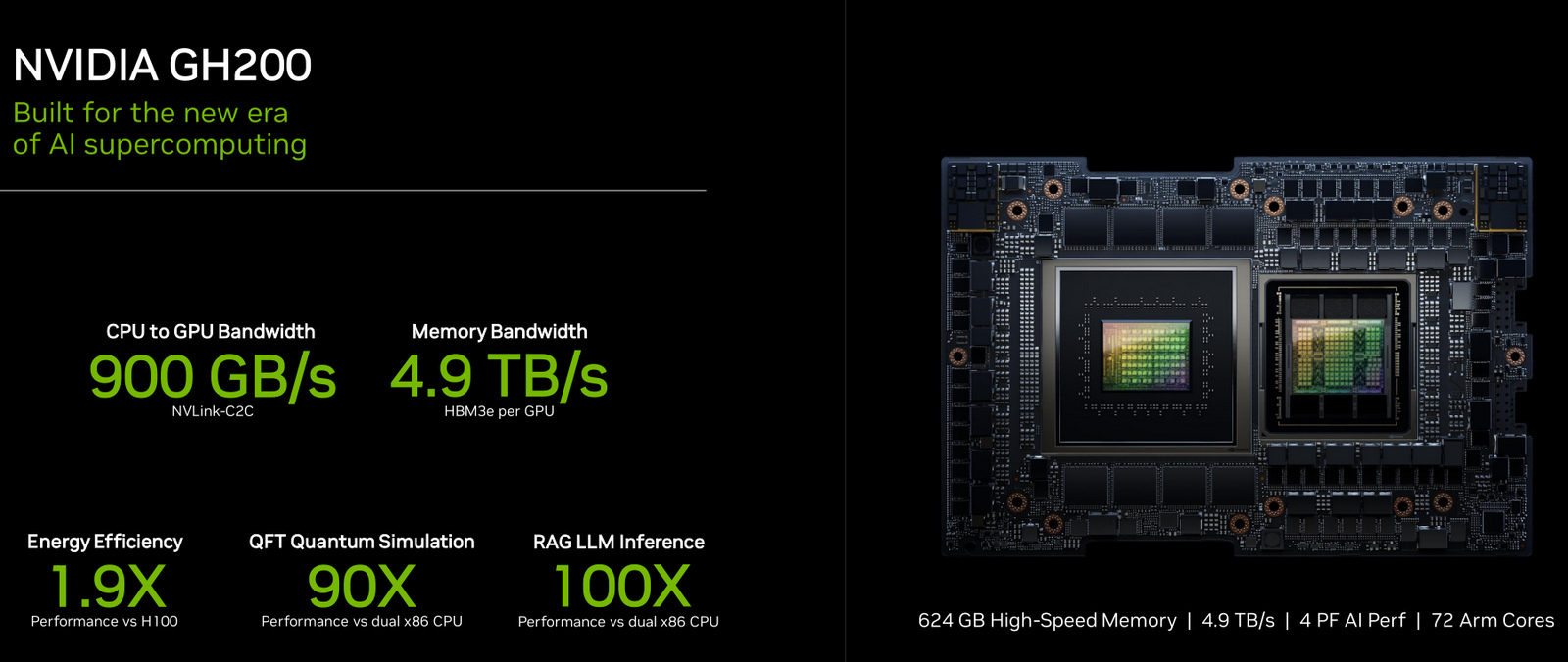

В паре с Arm-процессорами NVIDIA Grace со сверхбыстрым интерфейсом NVLink-C2C H200 образует суперчип GH200 Grace Hopper с HBM3e. Такие интегрированные модули NVIDIA позиционирует в качестве высокопроизводительных решений для работы с приложениями HPC и ИИ гигантского масштаба.

Ещё NVIDIA представила плату Quad GH200 с четырьмя суперчипами GH200, где все ускорители связаны друг с другом посредством NVLink по схеме каждый-с-каждым. Суммарно плата несёт более 2 Тбайт высокоскоростной памяти и 288 ядер Arm, а её производительность достигает 16 Пфлопс в FP8. До конца будущего года суммарная ИИ-производительность систем с GH200, по оценкам NVIDIA, достигнет 200 Эфлопс.

Ускоритель NVIDIA H200 станет доступен со второго квартала 2024 года.

Источник: 3DNews